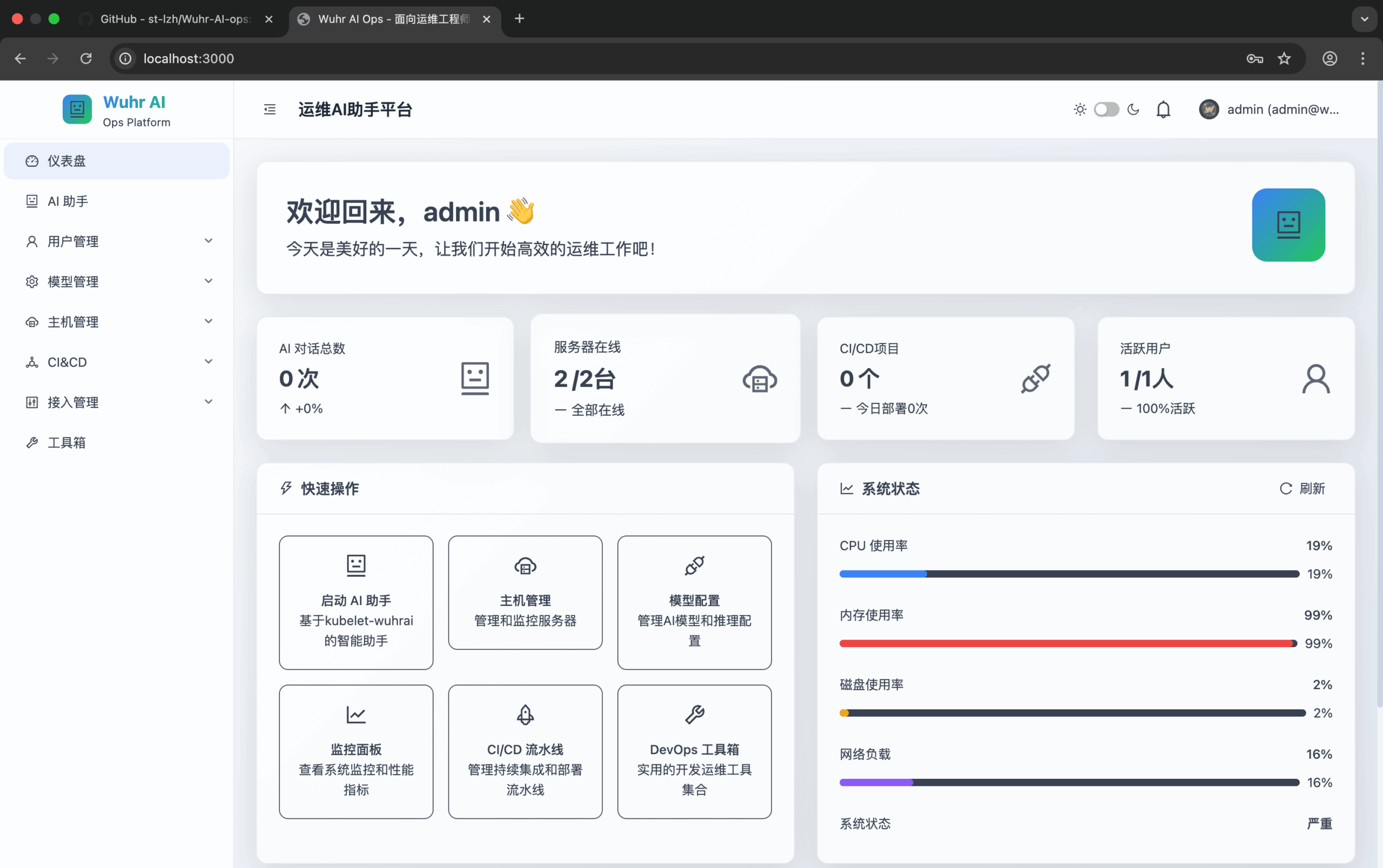

Wuhr-AI-ops

综合介绍

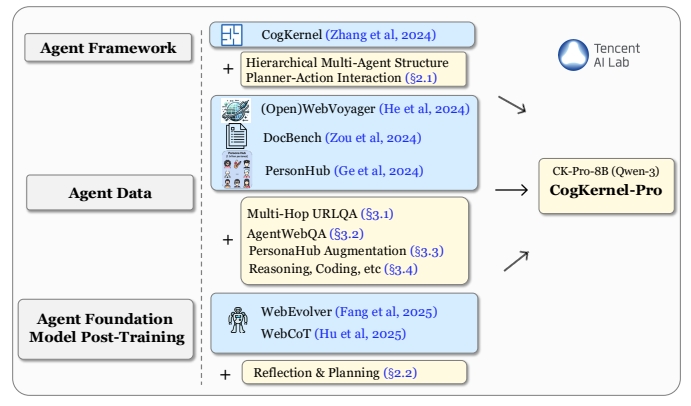

Wuhr AI Ops 是一个集成了人工智能的运维管理平台。它将多种运维工具整合到一个统一的界面中,旨在简化复杂的运维工作。平台内置了一个多模态AI助手,能理解并执行用户的自然语言指令,操作Linux系统或Kubernetes集群。除了AI助手,它还集成了实时服务器监控、日志集中分析和CI/CD自动化部署功能。运维人员可以通过这个平台管理服务器、设置监控告警、分析系统日志、配置和运行自动化部署流程。同时,系统还包含完整的用户和权限管理体系,确保不同角色的成员只能访问其被授权的功能,为运维团队提供了一个一站式的解决方案。

功能列表

- 智能AI助手: 集成多种大语言模型(如GPT-4o),能通过对话式自然语言执行运维操作,并能在Kubernetes和Linux命令模式间智能切换。

- 主机管理: 支持统一管理本地和远程Linux服务器,可进行SSH连接配置、状态监控和批量操作。

- 实时监控与日志分析: 集成Grafana提供性能监控面板,集成ELK进行日志的聚合、搜索和分析。

- CI/CD管理: 提供可视化的持续集成和持续部署流水线,支持与Jenkins集成,可管理包括K8s、Docker、Shell在内的多种部署模板。

- 权限管理: 拥有基于角色的访问控制(RBAC)系统,包含用户注册审批、权限分配和操作审计等功能。

- 模型管理: 允许用户接入和管理自己的AI模型,支持多种AI服务提供商的API配置。

- 工具箱: 提供常用的运维工具集合,如系统诊断、网络测试和文件传输等。

使用帮助

Wuhr AI Ops平台设计了简便的安装和使用流程。以下是详细的操作指南,帮助你快速上手。

系统要求

在开始安装前,请确保你的系统满足以下基本条件:

- 操作系统: Linux, macOS, 或 Windows

- Node.js: 18.0.0或更高版本 (推荐使用20.0+)

- npm: 8.0.0或更高版本 (推荐使用10.0+)

- Docker: 20.10.0或更高版本

- Docker Compose: 2.0.0或更高版本

- 硬件: 建议至少4GB内存和20GB可用硬盘空间

一键安装部署

项目提供了自动化安装脚本,能够检测并提示安装缺失的依赖,是推荐的安装方式。

- 克隆代码库首先,使用

git命令将项目代码克隆到你的本地电脑。git clone https://github.com/st-lzh/wuhr-ai-ops.git - 进入项目目录

cd wuhr-ai-ops - 执行安装脚本脚本分为国内和国外两个版本,主要区别在于使用了不同的软件镜像源以优化下载速度。

- 如果你在中国大陆,请使用中文安装脚本:

./install-zh.sh - 如果你在其他国家或地区,请使用英文安装脚本:

./install-en.sh

脚本在执行过程中会自动检测

Docker、Node.js等环境。如果发现有组件缺失,它会询问你是否需要自动安装。安装过程中,脚本会让你选择运行模式:- 前台运行模式: 适用于开发和测试,所有运行日志会直接显示在终端界面,方便调试。

- 系统服务模式: 适用于生产环境,会将应用注册为系统服务,实现开机自启和后台稳定运行。

- 如果你在中国大陆,请使用中文安装脚本:

访问和登录平台

安装完成后,你可以通过浏览器访问平台。

- 访问地址:

http://localhost:3000 - 默认管理员账户:

- 用户名:

admin - 邮箱:

admin@wuhr.ai - 密码:

Admin123!

- 用户名:

首次登录后,建议立即修改默认密码以保证系统安全。

核心功能操作流程

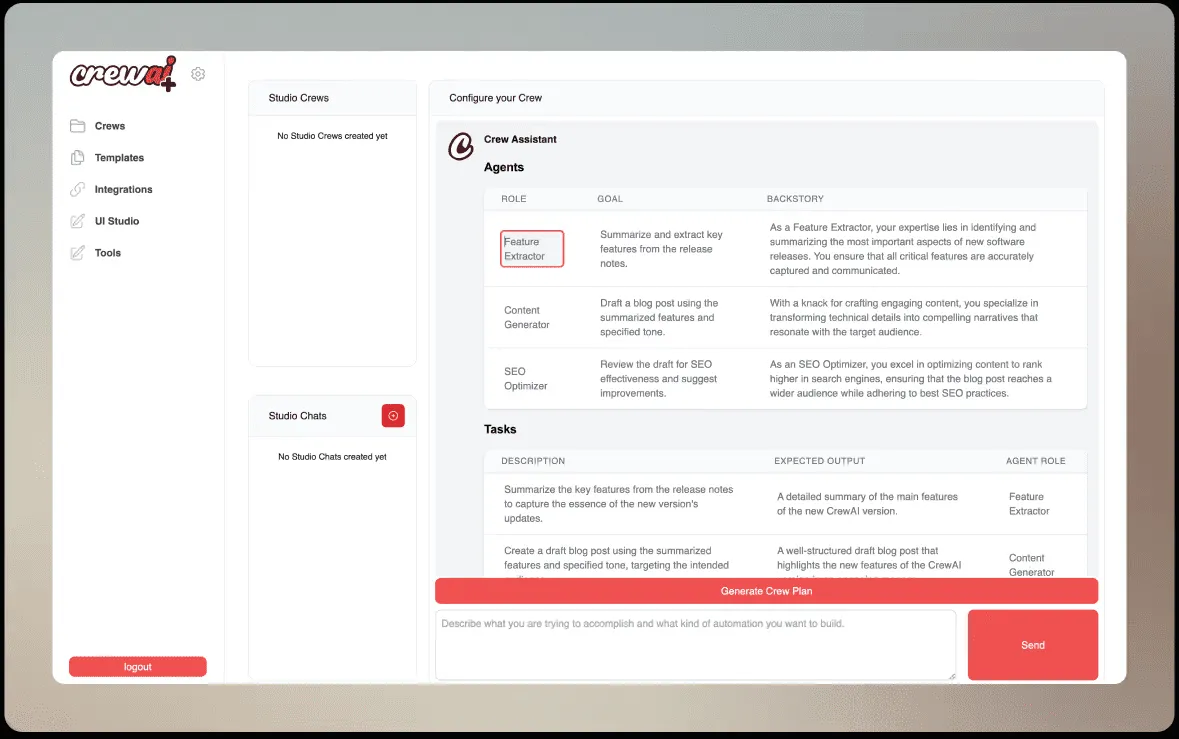

1. AI助手的使用

AI助手是平台的核心功能,它能让你用自然语言完成复杂的运维任务。

- 进入AI助手: 在左侧导航栏点击“AI助手”。

- 配置AI模型: 首次使用前,需要先配置AI模型。进入“模型管理”页面,点击“添加模型”,选择你的AI服务提供商(如OpenAI、Gemini等),并填入你的API密钥。

- 选择命令模式: AI助手支持

Kubernetes (K8s)和Linux两种命令模式。你可以通过界面上的切换按钮或使用快捷键Ctrl + K来切换。 - 发送指令: 在聊天框中输入你的运维指令。例如:

- 在Linux模式下,你可以输入:“检查当前服务器的CPU使用率最高的5个进程”

- 在K8s模式下,你可以输入:“列出default命名空间下所有的pod”

- 执行与反馈: AI助手会分析你的指令,生成对应的Shell或kubectl命令。你可以选择让其自动执行,执行结果会实时显示在界面上。

2. 管理主机

你可以将所有的服务器都添加到平台中进行统一管理。

- 添加新主机: 导航到“主机管理”页面,点击“添加主机”。

- 填写连接信息: 输入服务器的名称、IP地址、SSH端口号和登录用户名。你可以选择使用密码或SSH密钥进行认证。

- 测试连接: 填写完毕后,点击“测试连接”按钮,确保平台可以成功连接到你的服务器。

- 配置监控: 添加主机后,你可以进一步在“接入管理”中为其配置ELK和Grafana监控,以实现日志和性能数据的采集。

3. 配置CI/CD流水线

自动化部署可以极大提升发布效率。

- 创建部署模板: 进入“CI/CD管理”下的“模板管理”,根据你的需求创建部署模板,例如一个用于部署Docker容器的模板。

- 配置流水线: 在“持续部署”模块,创建一个新的部署流水线。你可以通过可视化的方式编排部署步骤,例如“拉取代码”、“构建镜像”、“推送镜像”和“在目标服务器上运行容器”。

- 关联Jenkins (可选): 如果你已经在使用Jenkins,可以在“Jenkins部署任务”中进行关联,将平台的CI/CD流程与Jenkins任务打通。

- 触发部署: 配置完成后,你可以手动触发流水线,或者配置代码仓库的Webhook来实现代码提交时自动触发部署。

应用场景

- 中小团队的统一运维中心对于资源有限的中小企业或开发团队,往往缺乏专职的SRE工程师和昂贵的商业运维软件。Wuhr AI Ops可以将团队内所有的服务器、容器和应用都集中到一个平台进行管理和监控,并通过AI助手降低日常运维的技术门槛。

- 云原生环境下的运维辅助在采用Kubernetes进行容器编排的环境中,运维人员需要记忆大量

kubectl命令。AI助手可以通过自然语言转换,自动生成并执行这些命令,例如查询Pod状态、查看容器日志或伸缩Deployment,显著提升了在云原生环境下的工作效率。 - 自动化部署与发布管理开发团队可以利用平台的CI/CD功能,为不同的项目和环境(开发、测试、生产)搭建标准化的部署流水线。通过审批流功能,可以确保每一次向生产环境的发布都经过了负责人审核,降低了误操作的风险。

- 快速故障排查与诊断当线上服务出现问题时,运维人员可以快速通过平台的日志中心(ELK)搜索相关错误日志,同时在监控面板(Grafana)上查看异常时间点的服务器性能指标。结合AI助手,可以直接在平台上执行诊断命令,缩短了故障排查的时间。

QA

- 如何为AI助手添加一个新的AI模型?你需要进入“模型管理”页面,点击“添加模型”。然后根据指引选择AI模型的提供商类型(例如是GPT系列还是Gemini系列),并填写该模型对应的API地址和访问密钥。保存后,就可以在AI助手设置中选择使用这个新模型。

- 为什么AI助手执行命令会失败?执行失败可能由几个原因造成:首先,请检查“主机管理”中对应服务器的连接状态是否正常。其次,确认执行该命令所需的用户权限是否足够(例如,执行某些系统级命令需要root权限)。最后,检查当前选择的命令模式(Linux或K8s)是否与你的指令匹配。

- 如何为一台新加入的远程主机配置监控?首先在“主机管理”页面成功添加你的服务器并确保连接通畅。然后,你需要导航到“接入管理”模块,在这里配置ELK和Grafana的连接信息。配置完成后,系统便会开始从该主机收集日志和性能数据,并在监控仪表盘上展示。

- 这个平台是否可以商用?根据项目的

LICENSE文件说明,个人学习和非商业用途是完全免费的。如果计划在商业环境中使用,或进行二次开发和重新分发,则需要联系项目作者(邮箱:1139804291@qq.com)获得授权。